OnCrawl a été construit pour répondre aux besoins du premier site e-commerce français en 2015. Cela signifie que nous avons dû adapter nos analyses et composer avec un site web de plus de 50 millions d’URLs dans un court laps de temps. Difficile pour un nouvel acteur, me direz-vous ? En réalité, notre infrastructure, dans laquelle nous avons investi près de 1,5 millions d’euros juste en R&D et qui a précédemment accompagné différents projets de données, a facilité ces analyses de grande envergure. Comme la distinction entre crawlers desktop et crawlers basés sur le cloud reste vague, nous avons pensé qu’il serait utile d’expliquer pourquoi OnCrawl a bien plus à offrir qu’un simple crawler desktop. De nos fortes capacités de scalabilité, aux intégrations tierces en passant par la vitesse d’analyse : découvrez toutes les possibilités offertes par OnCrawl.

Passer à l’échelle vers l’infini et l’au-delà

Les crawlers desktop sont limités dans leur capacité de crawl à cause des ressources et de la mémoire utilisées par les machines sur lesquelles le programme tourne. Il est probable qu’ils ne soient en mesure de crawler que quelques milliers d’URLs par crawl. Si cela peut convenir pour des petits sites web, le crawl prendra tout de même plus de temps par rapport à un crawler SaaS (Software as a Service). Les crawlers basés sur le cloud sont distribués à travers de nombreux serveurs. Il n’existe donc pas de limite de vitesse ou de taille d’une machine.

Cela signifie qu’il n’y a aucun site que nous ne pouvons pas crawler. Nous travaillons aussi bien pour des petits sites web que pour de très grands sites, dont des entreprises du Fortune 500. Nous avons en effet développé notre crawler SEO après que Cdiscount, le plus gros site e-commerce français, nous ait demandé de leur construire une solution sur-mesure pour gérer leurs 50 millions d’URLs et leurs besoins SEO en un seul et même crawl. De plus, notre scalabilité nous a permis d’être élu deux années de suite ‘Best SEO Tool’ aux European Search Awards, la cérémonie leader du secteur du search. Actuellement, nous collectons près de 25 millions d’URLs par jour et par site, où approximativement 1 milliard de pages web et 150 milliards de liens par mois. Vous pouvez en savoir plus sur notre technologie et pourquoi nous respectons les normes RGPD ici.

Vitesse personnalisée, capacités larges

Notre application étant basée sur le cloud, vous n’avez pas besoin de penser aux ressources et capacité de vitesse de votre machine. Cela signifie aussi qu’il n’y a pas de restrictions sur la durée ou le nombre de crawls qui peuvent être lancés. Vous pouvez paramétrer autant de crawls que votre abonnement ne le permet et faire tout à fait autre chose pendant que nous crawlons votre site. En utilisant une solution basée sur le cloud, vous pouvez également fermer la fenêtre de l’application et attendre que l’analyse soit terminée. Le crawl est autonome et ne nécessite aucune surveillance. OnCrawl vous permet de programmer des crawls basés sur vos besoins SEO, que vous ayez besoin de crawler votre site une fois par semaine ou par mois. Vous pouvez aussi décider d’accélérer vos analyses si vous avez besoin d’aller plus vite.

Puisque l’application OnCrawl peut être utilisée pour crawler n’importe quel site web, notre robot va suivre les directives de Crawl-Delay indiquées dans le fichier robots.txt sur le site ciblé (s’il existe).

Autrement, nous limitons le taux de crawl à une page par seconde pour que notre robot ne soit pas trop agressif avec le site ciblé.

Lorsqu’un site a une directive de Crawl-Delay plus élevée que 1, notre application émet un avertissement pour vous prévenir que le crawl sera plus lent que la vitesse demandée.

Si le Crawl-Delay est plus élevé que 30, nous affichons une erreur. Nous ne vous autoriserons tout simplement pas à configurer un crawl avec un délais de crawl aussi haut.

La seule manière de configurer un crawl avec ces pré-requis est d’utiliser un fichier robots.txt virtuel.

Pour ce faire, vous devez d’abord valider le projet avec votre compte Google Analytics, afin que nous puissions nous assurer que vous possédez bien le domaine que vous souhaitez crawler.

Nous avons différents paramètres qui vous permettent de prendre le contrôle sur votre crawl :

- Accélérer votre crawl ;

- Mettre en pause, arrêter, relancer ou annuler un crawl ;

- Programmer un crawl pour éviter les périodes de pic de trafic et ne pas surcharger votre serveur lorsque notre robot analyse votre site ;

- Voir en temps réel les pages qui ont été récupérées, le nombre d’URLs que nous avons trouvé à ce stade et ralentir le crawl en cas de problème.

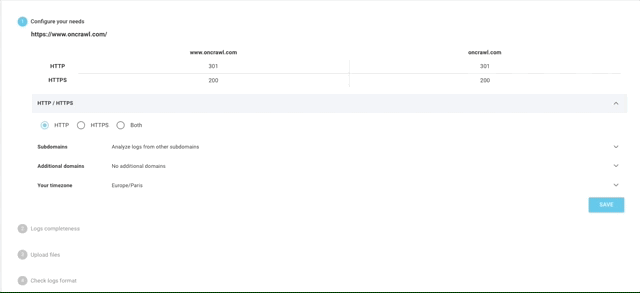

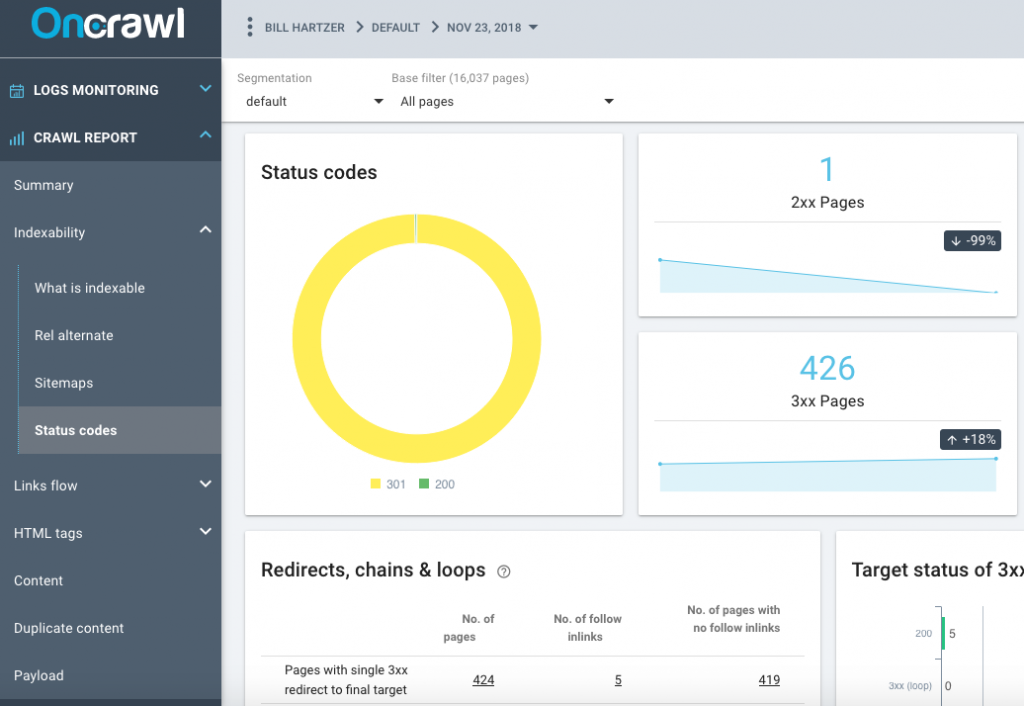

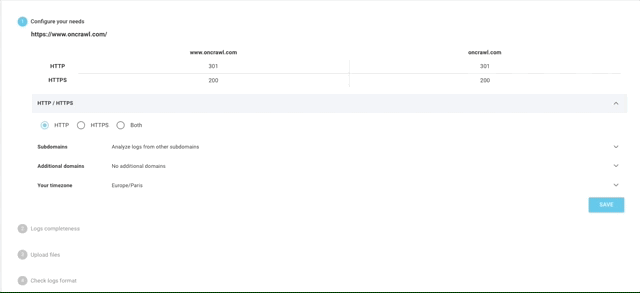

L’analyse de logs simplifiée

OnCrawl est bien plus qu’un simple crawler SEO. Au cours des dernières années, nous avons également mis au point un puissant analyseur de fichiers de log SaaS qui propose des analyses qu’aucune autre solution SEO n’avait apporté jusqu’ici. Des fichiers de log complets permettent de parfaitement refléter la vie de votre site. Qu’il s’agisse des visiteurs, robots, pages ou ressources affichées, toute l’activité de votre site y est renseignée.

Avec des informations comme l’adresse IP, le status code, le user-agent, le referrer et d’autres données techniques, chaque ligne de logs (données issues du serveur) peut vous aider à compléter votre analyse de site, qui est souvent basée sur des analytics (données basées sur vos clients).

Notre analyseur de logs supporte n’importe quel type de formats de log, des standards comme IIS, Apache sur Ngnix à des formats plus personnalisés. Il n’y a pas d’analyses que nous ne pouvons pas gérer. Nous permettons également à nos utilisateurs de récupérer leurs données de logs directement depuis des solutions tierces comme Splunk, ELK / Elastic Stack, Amazon S3, OVH (ES) ou Cloudflare.

Cela signifie que vous n’aurez plus de problèmes si vous utilisez un hébergeur de logs spécifique, comme cela a pu être le cas précédemment avec nos concurrents. Cela permet également aux services juridiques frileux de partager leur logs de le faire en toute confiance, puisque ceux-ci restent hébergés chez leurs solutions de gestion des logs. A noter que l’application OnCrawl gère les données personnelles sous forme d’adresses IP des visiteurs de votre site Web. Ces informations sont nécessaires pour distinguer de manière fiable les Googlebots des autres visiteurs.

Les adresses IP ne sont pas stockées dans l’application OnCrawl. Ces données n’existent que dans le fichier d’origine que vous téléchargez sur votre FTP privé et sécurisé.

Par ailleurs, le téléchargement automatique de vos fichiers de log se fait un FTP privé et sécurisé. Cela ne nécessite que quelques étapes pour compléter votre analyse de fichiers de log.

Vous pouvez aussi surveiller le traitement de vos fichiers en temps réel et voir si des erreurs bloquent leur téléchargement.

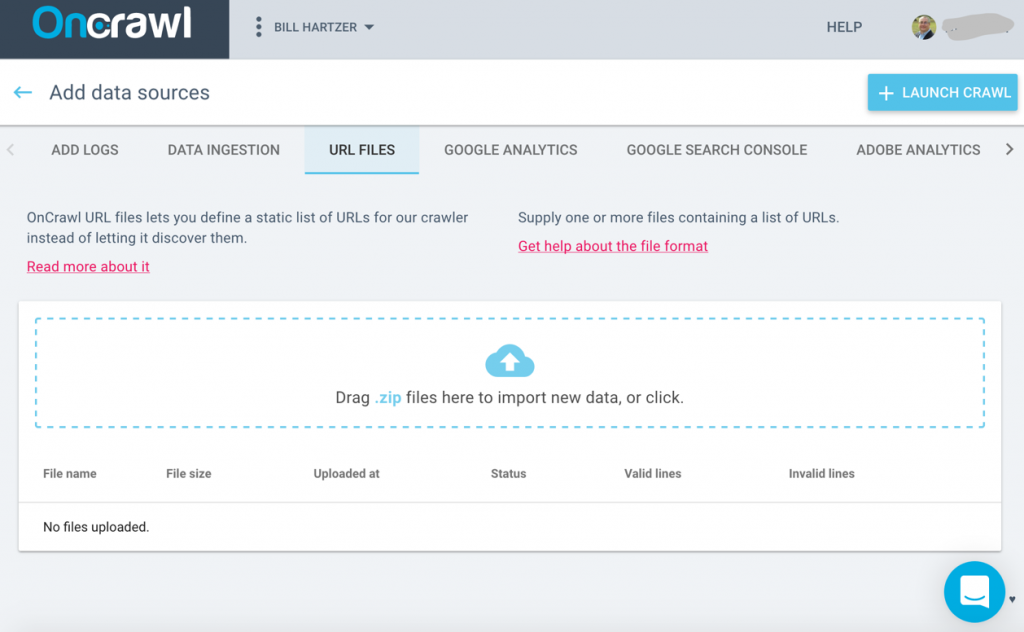

Des intégrations tierces illimitées

OnCrawl a travaillé sur le développement de connecteurs intégrés avec les solutions leaders sur le marché du search qui sont indispensables pour les SEOs : Google Search Console, Google Analytics, Adobe Analytics ou Majestic, pour en nommer quelques unes. Intégrer ces solutions dans votre audit n’a rien de redondant : elles vous procureront une vue plus complète de la performance et de la santé de votre site et vous montreront comment les robots et visiteurs se comportent réellement sur votre site. Vous économiserez également beaucoup de temps et d’efforts car vous n’aurez pas besoin de manier ces données manuellement dans des fiches de calcul Excel ou multiplier les connexions à différents outils.

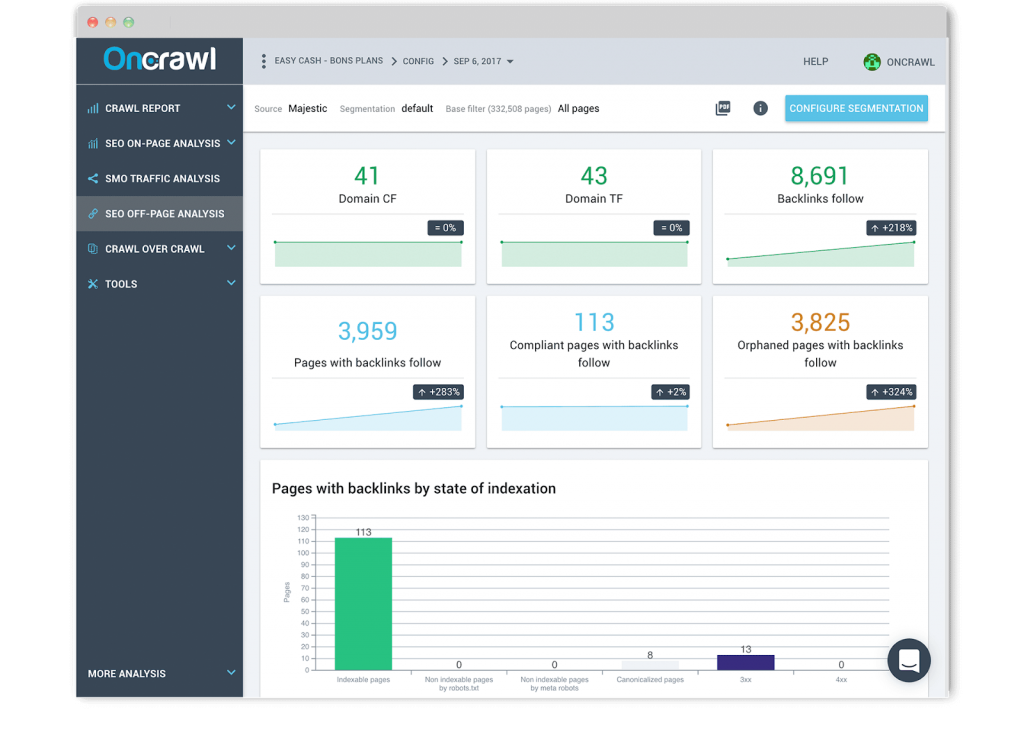

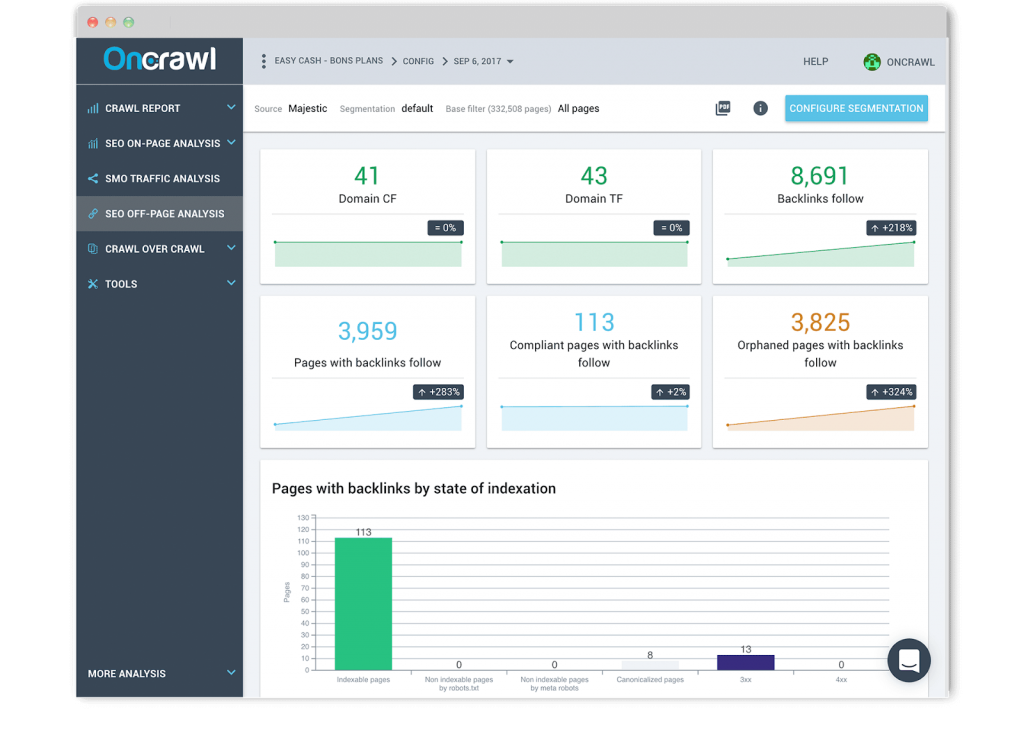

Rapport de backlink

Nous avons construit une relation de confiance avec Majestic, la solution leader d’analyse de liens. Nos analyses croisées vous permettent de combiner vos données de crawl et de logs avec vos données de backlink pour comprendre leur influence sur votre trafic SEO et la fréquence de crawl. Une fois que vous aurez mis en place une segmentation à l’échelle du site de groupes de pages personnalisés en fonction de vos KPIs les plus importants. Vous pouvez également visualiser le nombre de backlinks en fonction du taux de profondeur de la page ou examiner le nombre de backlinks qui a une influence sur le comportement de Google.

Les analyses que nous proposons, dans lesquelles les données de backlinks sont corrélées et combinées au niveau de l’URL et du passage du bot, sont actuellement uniques sur le marché.

Rapport de classement

Nous avons également développé un connecteur unique avec la Google Search Console pour comprendre comment votre site est trouvé et indexé et si vos optimisations on-page ont un impact sur le trafic et l’indexation. Nous fournissons des insights standards mais exhaustifs sur la distribution de mots-clés, les impressions, les clics et le taux de clic au fil du temps, que ce soit sur desktop ou mobile, pour des mots-clés brandés ou non brandés ou en fonction de vos groupes de pages. Plus important, nous offrons aussi des analyses uniques qu’aucun de nos concurrents ne propose.

OnCrawl utilise vos segmentations et données issues de vos fichiers de log pour interpréter vos données de classement. Ainsi, vous pouvez identifier les caractéristiques communes des pages qui se classent et de celles qui ne se classent pas en fonction de la profondeur, de la popularité interne, du nombre de mots, des liens internes, du temps de chargement et de l’évaluation des titres. Au-delà de ça, vous pouvez aussi examiner l’impact de la longueur de la description et des données structurées sur le taux de clic.

Enfin, OnCrawl Rankings vous permet de combiner vos données de crawl, logs et Search Console à l’échelle pour mettre en avant les pages classées et comprendre si le budget de crawl influence vos positions. Aucun autre crawler, que ce soit desktop ou basé sur le cloud, ne propose ce type de fonctionnalités.

Rapport Analytics

Nous vous permettons de vous connecter à votre Google Analytics ou Adobe Analytics (ex-Omniture) pour comprendre comment le SEO on-page et technique affecte les performances de trafic organique depuis les moteurs de recherche. Nous vous aidons à surveiller les performance de trafic SEO et le comportement des utilisateurs en fonction de chaque section de votre site.

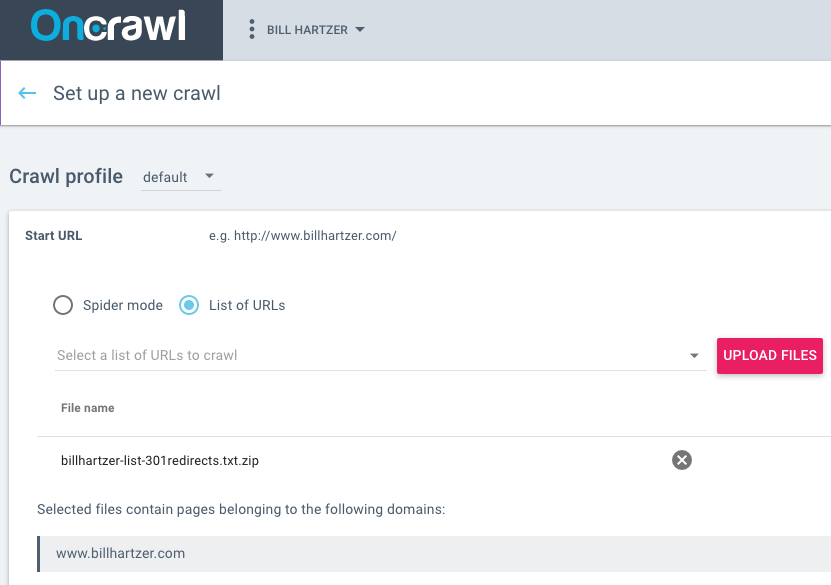

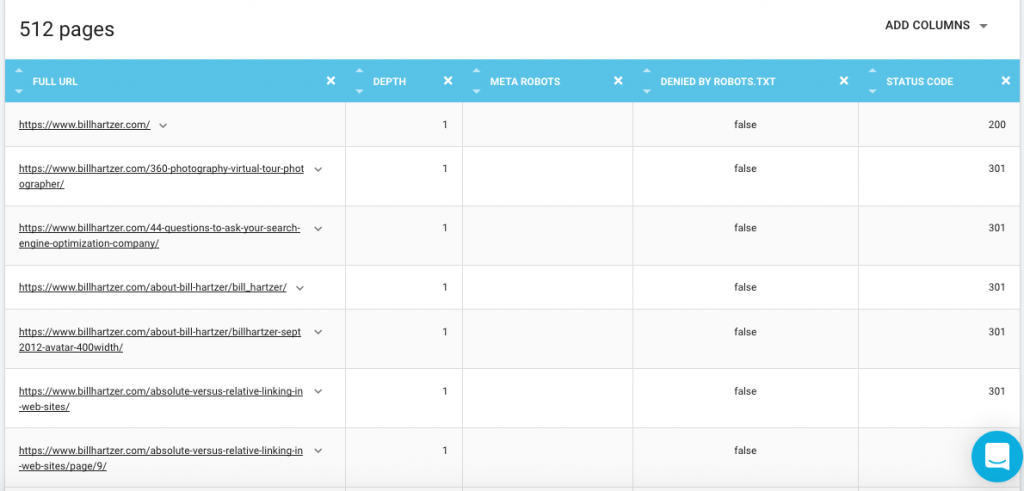

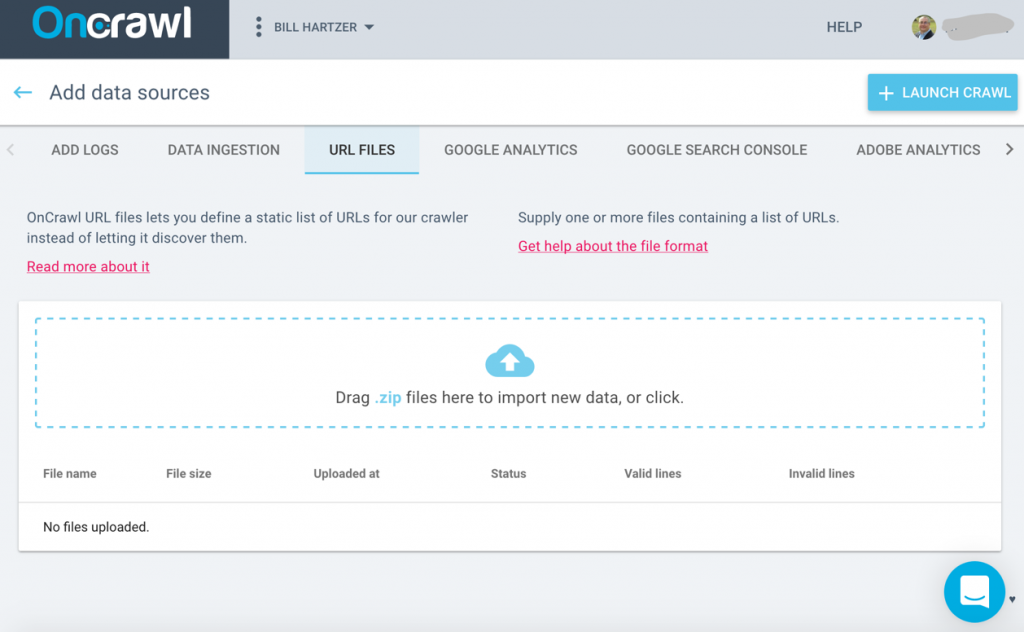

Ingestion de CSV

Bien que nous travaillons sans cesse sur de nouvelles intégrations pour des solutions tierces, nous ne voulions pas vous laisser sans la possibilité d’intégrer un type de données particulier dont vous pourriez avoir besoin pour vos audits SEO technique. C’est pourquoi, nous vous permettons de télécharger vos fichiers CSV à l’échelle (vous pouvez télécharger des millions de lignes) pour ajouter une nouvelle couche de données au niveau de l’URL. Vous pouvez construire vos propres segmentations et filtres basés sur ces données particulières (données de classements, CRM, business, Google Ads,…) pour voir si vos pages les plus stratégiques remplissent vos objectifs.

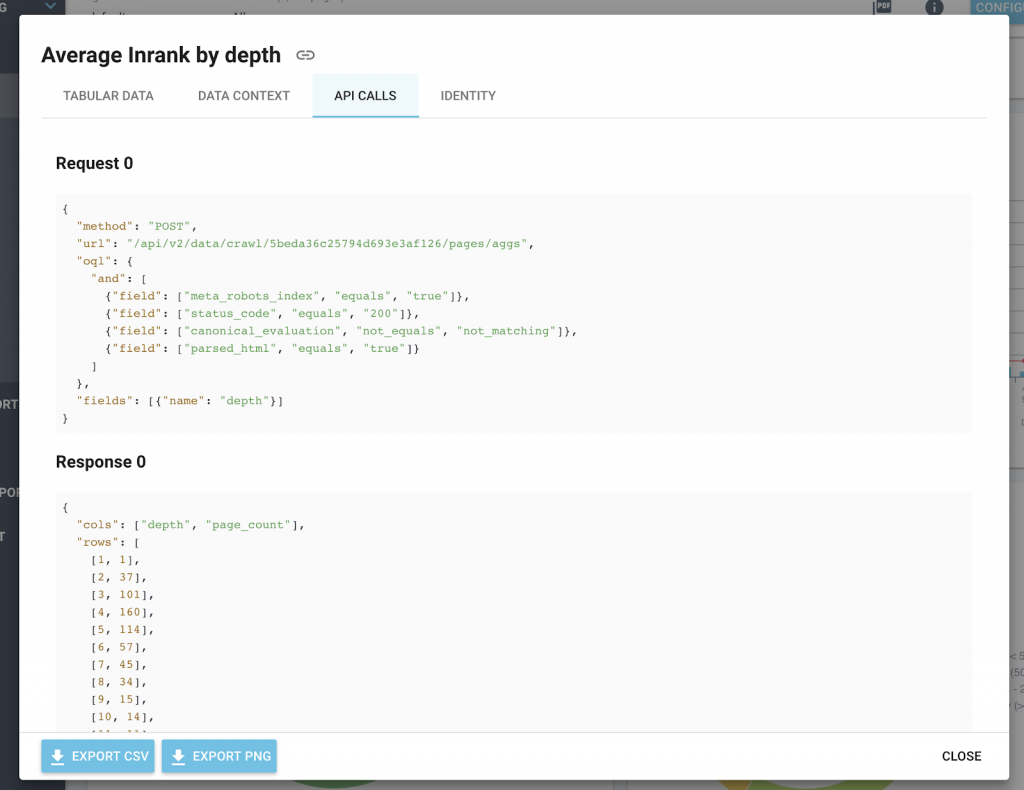

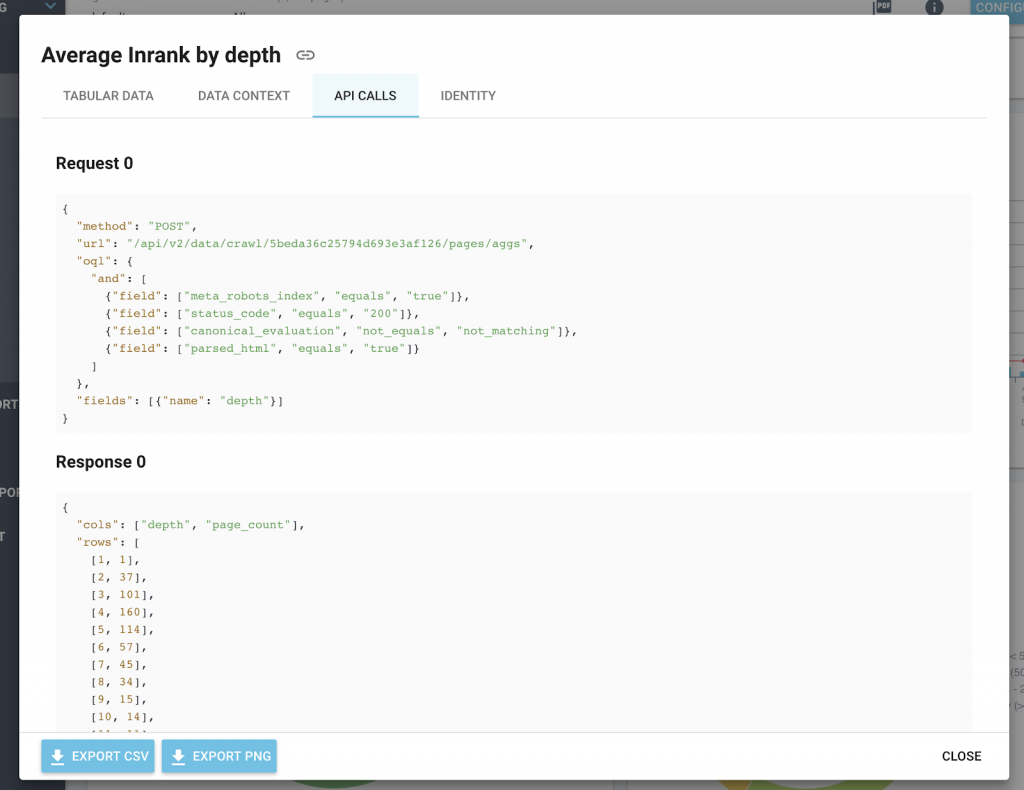

API ouverte, analyses personnalisées

OnCrawl est basé sur une plateforme construite autour d’une API. L’API REST d’OnCrawl est utilisée pour accéder à vos données de crawl et gérer vos projets et vos crawls. Afin d’utiliser cette API, vous devrez avoir un compte OnCrawl, un abonnement actif et un access token.

Vous pouvez créer votre propre application pour réclamer cette API très facilement. Cela peut être fait en utilisant une API token générée par le compte utilisateur ou en utilisant une application OAuth pour se connecter à OnCrawl en utilisant le compte utilisateur.

Utiliser notre API, vous permet d’écrire des applications qui tirent profit des nombreuses fonctionnalités OnCrawl déployées dans votre propre environnement, en utilisant le langage de programmation et les plateformes que vous préférez. Cela signifie que vous pouvez créer des rapports personnalisés, intégrer vos données dans d’autres plateformes et automatiquement déclencher un crawl lorsqu’un site est mis à jour.

De plus, pour rendre cette intégration plus simple pour vous, tous nos graphiques incluent les appels API et le format de réponse dans l’icône d’information.

Tendances et optimisations au fil du temps

OnCrawl organise vos crawls par date au sein de vos projets. Nous stockons vos données de crawl lorsque votre abonnement est actif, ce qui signifie que vous pouvez continuer de suivre des mois ou même des années d’analyses. Notez cependant que si vous utilisez notre fonctionnalité de Log Monitoring, l’application OnCrawl gère les données personnelles dans le format de l’adresse IP des visiteurs de votre site. Cette information est utilisée afin de distinguer la fiabilité entre les Googlebots et les autres visiteurs. Les adresses IP ne sont pas stockées dans l’application OnCrawl. Les données existent seulement dans le fichier originel que vous avez téléchargé dans votre FTP privé et sécurisé.

Nous offrons également diverses fonctionnalités qui vous permettent de comparer deux crawls, basés sur la même configuration pour repérer les tendances et changements au fil du temps. Il s’agit d’une très bonne manière de comparer une version de pré-prod et une version live pour vérifier si tout s’est bien déroulé au cours d’une migration.

Vous pouvez aussi partager vos projets avec vos collègues ou clients, ce qui est un très bon moyen de prouver la valeur de vos optimisations et de partager vos résultats.

Montre l’évolution du contenu dupliqué entre deux crawls

Montre l’évolution des mouvements de profondeur entre deux crawls

Analyse sémantique encore et encore

L’innovation est au coeur de notre ADN et nous avons pour objectif d’évangéliser le SEO technique depuis des années. Avec près de 15 ans d’expérience en traitement de problèmes liés au langage naturel, Tanguy Moal, CTO chez OnCrawl, nous a aidé à fusionner les technologies de sémantique et de Big Data pour donner du sens aux gigantesques volumes de données disponibles sur le web. Nous avons mis au point le tout premier détecteur de contenu similaire en utilisant l’algorithme Simhash.

Groupe de pages similaires avec une évaluation canonique. Groupes qui peuvent être filtrés par nombre de pages ou pourcentage de contenu similaire.

Nous avons récemment travaillé sur un détecteur de contenu sous forme de carte thermique qui aide nos utilisateurs à identifier les blocs de contenu unique et le pourcentage de duplication à travers les pages web et le site en général. La sémantique fait partie de notre crawler SEO : les analyses n-grams qui sont disponibles depuis le début, aident les utilisateurs à mieux comprendre quelles séquences de mots sont distribuées au sein du site. Nous sommes le seul crawler basé sur le cloud avec de telles capacités. Dans un secteur où les recherches conversationnelles sont de plus en plus courantes, le SEO sémantique vous aide à améliorer le trafic d’un site grâce à des méta données qui ont du sens et à un contenu sémantiquement pertinent qui peut clairement fournir une réponse pour une intention de recherche spécifique.

OnCrawl est bien plus qu’un crawler desktop et offre des analyses SEO inégalées basées sur le cloud. OnCrawl vous permet d’agir pour réellement comprendre comment les moteurs de recherche se comportent sur votre site et créer votre stratégie SEO avec confiance.

[Read More ...]