Des fichiers de logs complets sont un parfait reflet de la vie de votre site. Qu’il s’agisse de visiteurs ou de bots, de pages affichées ou de l’appel à des ressources les composants, toute activité sur votre site est écrite dedans.

Avec des informations comme l’Adresse IP, le Status Code, le User-Agent, le Referer et d’autres données techniques, chaque ligne de logs (données côté serveur) peut vous aider à compléter l’analyse de votre site basée le plus souvent sur un Analytics (plus axés sur le côté client).

Mais les données que vous ne trouverez que dans vos logs peuvent à elles-seules vous permettre d’orienter votre stratégie SEO.

1. L’état de santé de votre site

Parmi les informations que l’on retrouve dans les logs, le Status Code, le Poids du Document (ou Response Size) et le Temps de Réponse (ou Response Time) sont d’excellents indicateurs de l’état de santé de votre site.

En effet, il n’est pas rare de constater, par exemple, une baisse de trafic, de conversion (pour les sites marchands) ou d’autres indicateurs, sans que nous ne comprenions pourquoi en nous basant sur les données d’un Analytics. Et l’explication est parfois du côté technique.

Parmi les pistes à envisager, on en retrouve donc quelques unes directement liées aux 3 champs précédemment évoqués.

Exemple 1 : Une hausse du nombre d’erreurs serveur (les “5xx”) pourrait indiquer des soucis techniques qui peuvent passer inaperçus lors d’un simple contrôle de votre site en naviguant de page en page.

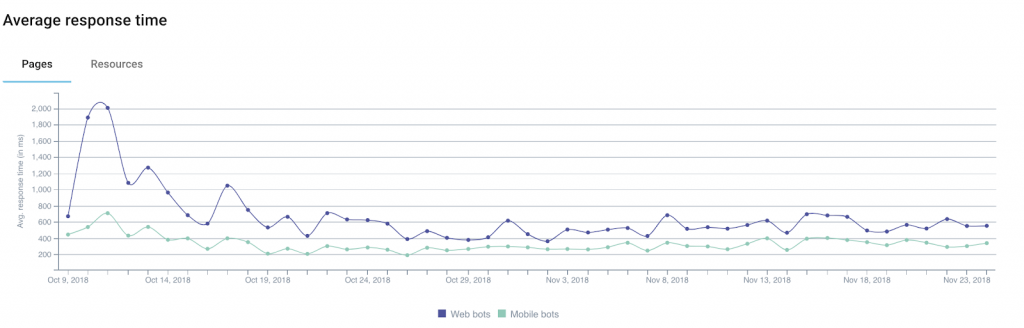

Exemple 2 : Plusieurs études ont démontré l’impact du temps de chargement sur le taux de transformation des sites e-commerce. Une baisse de votre chiffre d’affaire pourrait être corrélée à une hausse du temps de chargement de vos pages.

Google a d’ailleurs mis à disposition une calculatrice vous permettant de simuler le rapport entre temps de chargement et les revenus de votre site (à prendre toutefois avec des pincettes).

Exemple 3 : Il peut arriver que votre serveur, suite à divers soucis techniques, renvoie des pages vides. La simple surveillance du Status Code pourrait ici ne pas suffire à vous alerter. C’est pourquoi il semble pertinent d’ajouter au monitoring de votre site l’évolution du Poids du Document, ces pages vides (ou blanches) étant généralement plus “légère” qu’à l’accoutumé.

En complément, en segmentant votre site, en vous basant, par exemple sur les différents types d’URL/de pages, vous isolerez plus facilement les sources de problème et la résolution des différentes soucis techniques sera radicalement simplifiée.

2. La Fréquence de Passage des Bots

Pour les membres de la communauté SEO, les Logs représentent une mine d’informations utiles pour tenter de comprendre au mieux comment les robots des moteurs de recherche (pour ne citer qu’eux) “consomment” leur(s) site(s).

Ils permettent par exemple de savoir quand les bots sont passés pour la première ou la dernière fois sur une page.

Prenons l’exemple d’un site d’actualité qui a donc logiquement besoin que les moteurs de recherche indexent au plus vite les contenus les plus “frais”. Consulter le(s) champ(s) de logs indiquant la date et l’heure permet de définir le temps moyen qui s’écoule entre la publication d’un article et sa découverte par les moteurs de recherche.

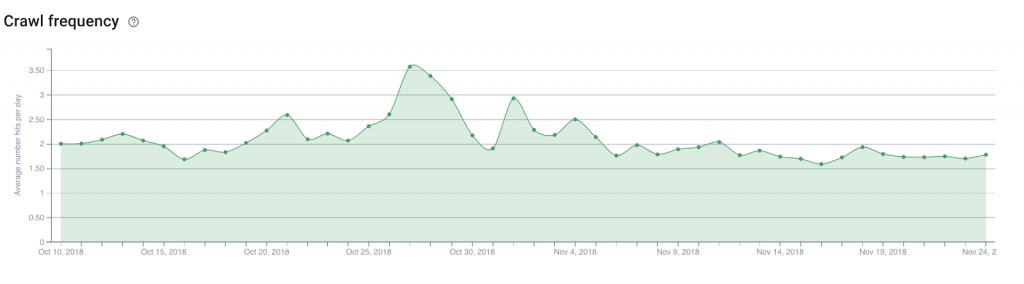

De là, il sera intéressant d’analyser, par exemple, le nombre de passages quotidiens des bots (ou fréquence de crawl) sur la page d’accueil du site, les pages de catégories, etc. afin de déterminer où placer des liens vers les articles récents que l’on souhaite donc faire découvrir au plus vite.

La même logique peut être appliquée notamment sur un site e-commerce afin de faciliter la découverte des produits nouvellement entrés dans le catalogue, ceux que l’on souhaite pousser pour répondre à un phénomène de mode émergent, …

3. Le Crawl Budget

Le Crawl Budget (sorte de crédit de crawl alloué à un site par Google et ses pairs) est une notion chère aux SEO et son optimisation fait partie des tâches à ne pas négliger.

Sans les logs, seule la Search Console (ancienne version pour le moment) permet de connaître dans les grandes lignes le “budget” que les moteurs de recherche consacrent à un site. Mais le niveau de précision de ces données ne permet finalement pas de savoir où placer nos efforts. D’autant plus que les données remontées sont en fait une agrégation des données cumulées de tous les bots de Google.

En revanche les logs, grâce à une analyse des champs URL et User-Agent, nous permettent d’identifier quelles pages (ou ressources) les bots consultent et dans quelle proportion.

Ces informations vous permettent de savoir si par exemple les Googlebots parcourent massivement des pans de votre site qui ne représentent aucun intérêt pour le SEO, gaspillant de fait du budget qui serait bénéfique à d’autres pages.

De ce type d’analyse peut notamment découler votre stratégie de maillage, votre gestion du fichier robots.txt, la balise meta dédiée aux robots, etc.

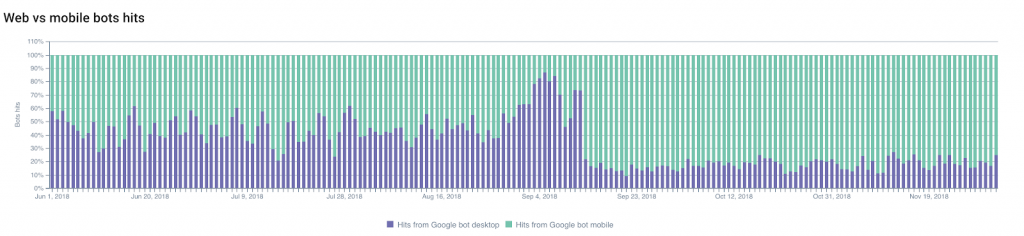

4. Mobile First, Migration

Certains l’attendent, d’autres en ont peur, mais arrivera sans doute un jour où vous recevrez un email de Google vous indiquant que votre site a été basculé sur le fameux Index Mobile First.

Cela peut-être anticipé en suivant l’évolution du ratio entre le nombre de passages des Googlebots Desktop et leurs équivalents Mobile.

La part de crawl par les Googlebots Mobile progressera généralement de manière à ce que vous puissiez anticiper la bascule.

D’un autre côté, le fait de ne pas voir ce ratio évoluer peut aussi être un indicateur non négligeable concernant la conformité de votre site par rapport aux critères d’évaluation de Google qui doivent motiver le changement d’index.

Autres changements, mais cette fois maîtrisables, qui peuvent être surveillés : une migration (par exemple de HTTP vers HTTPS) ou une modification de la structure de votre site.

Si on reste sur le premier cas, à savoir un changement de protocole, la prise en compte des URL sécurisées et des redirections, ainsi que “l’oubli” progressif de l’ancienne version ou tout autre point d’attention, peuvent très facilement être monitorés grâce au logs.

Le suivi de l’évolution des Status Codes sera ici votre meilleur allié.

5. Les Petits Curieux

Vous êtes un•e excellent•e SEO et vos efforts ont payé !

Résultat, vos concurrents (et autres curieux) veulent comprendre les raisons de votre succès et décident donc de crawler l’intégralité de votre site.

C’est mal. Mais ce n’est pas rare (au contraire même).

Le but pour vous maintenant est de les identifier.

Les plus subtils tenteront de faire passer leur propre bot pour un Googlebot en utilisant un des User-Agents de Google. Et c’est là que l’Adresse IP présente dans les logs peut prendre une tout autre utilité.

En effet, les Googlebots (pour ne citer qu’eux) n’évoluent que via des tranches d’adresses IP bien bornées. Google conseille d’ailleurs de procéder à une résolution de DNS inversée afin de s’assurer de l’origine des bots estampillés Googlebot.

En cas d’échec de ce test, les résultats (ou ceux d’une géolocalisation de l’IP) pourraient vous aider à prendre des décisions.

Pour l’anecdote, le spécialiste de la sécurité informatique Imperva Incapsula avait mené une étude parue en 2016 montrant qu’à l’époque, 28,9% de la bande-passante analysée était consommée par de “mauvais bots” (contre 22,9% par de “bons bots” et 48,2% par les internautes). Jeter un oeil à ses logs permettrait donc d’éviter, entre autre, une surconsommation des ressources de vos machines en détectant les bots néfastes.

[Read More ...]

No comments:

Post a Comment